執筆者:ダニエル・パーカー、アミット・チュダスマ • 2023 年 11 月 14 日

目次

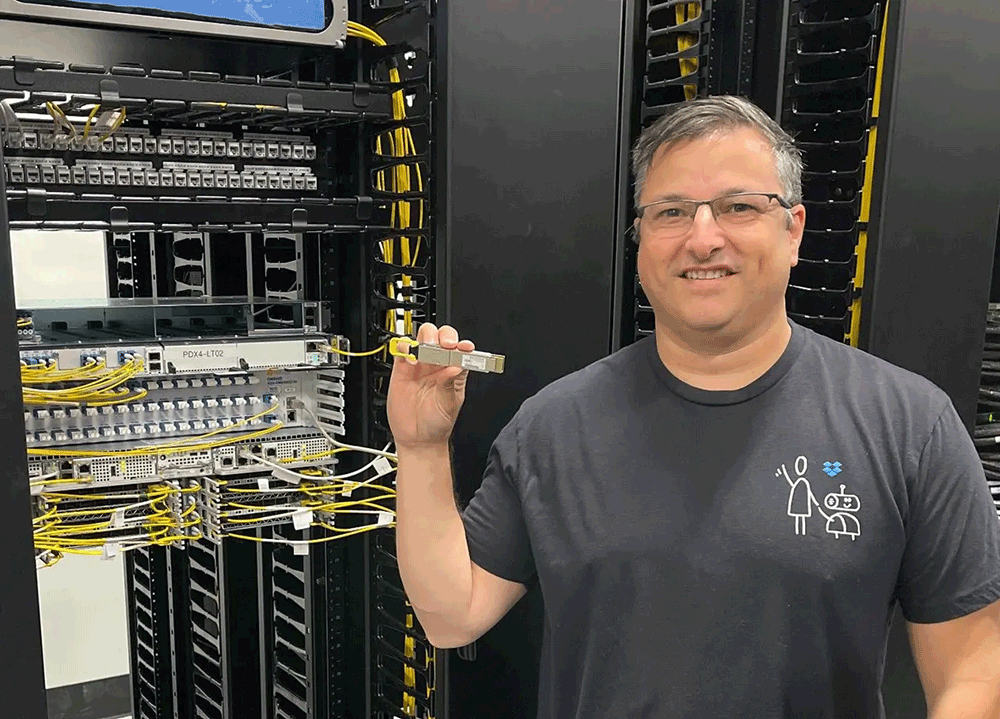

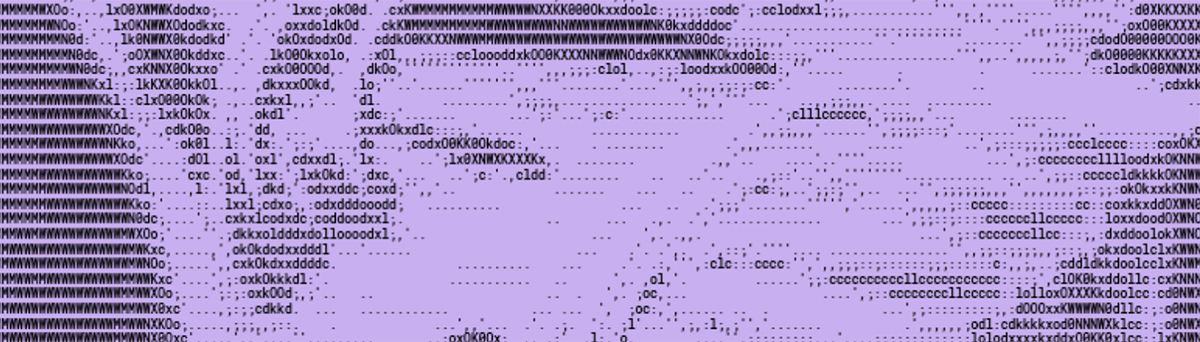

Dropbox では、AI を活用したツールや機能により、お客様がデータを検索し、整理し、理解するための仕組みを急速に変革しています。Dropbox Dash は AI を活用したユニバーサル検索機能をアプリ、ブラウザ タブ、クラウド ドキュメントのすべてに提供し、Dropbox AI はファイルの内容を要約し、コンテンツに関する質問に回答します。このほど Dropbox のネットワーキング チームは、新規および将来の AI ワークロードの帯域幅要件を満たし、持続可能性の目標への取り組みを続けるため、効率の高い最先端の毎秒 400 ギガビット(400G)イーサネット テクノロジーを使用した当社初のデータセンター アーキテクチャを設計し、運用を開始しました。

400G は、パルス振幅変調や前方誤り訂正が可能なデジタル信号処理チップなどの高度な技術を組み合わせて使用し、1 つのリンクで前身である 100G の 4 倍のデータ レートを達成します。光学系を備えた 1 つの 400G ポートは、4 つの個別の 100G ポートよりもコスト効率に優れ、消費電力も少ないため、400G を採用することで、電力使用量とケーブル敷設延長を大幅に削減しながら、最新データ センターの帯域幅を実質的に 4 倍にすることができました。また、新しい設計では、データ センターとネットワーク バックボーンの接続方法を合理化し、これまで 3 つに分かれていたデータ センター間接続デバイスの役割を 1 つに統合することで、さらなるコストと消費エネルギーの削減を実現しています。

400G は比較的新しいテクノロジーであり、100G ほど広く業界で採用されていませんが、その状況は変わり始めています。本ブログでは、Dropbox が他社に先駆けて 400G の導入を選択した理由と、最初の 400G データ センターの設計要件とアーキテクチャの詳細について説明し、アーリー アダプターとして直面した課題と学んだ教訓に触れます。最後に、このエキサイティングな新しいテクノロジーを用いて構築を続けるための今後の計画について説明します。

1. 400G を選択した背景

Dropbox は、単なるファイル ストレージ企業として 2008 年に創業して以来、長い道のりを歩んできました。今では、大規模なグローバル クラウド コンテンツ プラットフォームとなり、7 億人を超える登録ユーザーに AI を活用した複数の製品ポートフォリオを提供するとともに、8,000 億を超えるコンテンツを安全に保管しています。

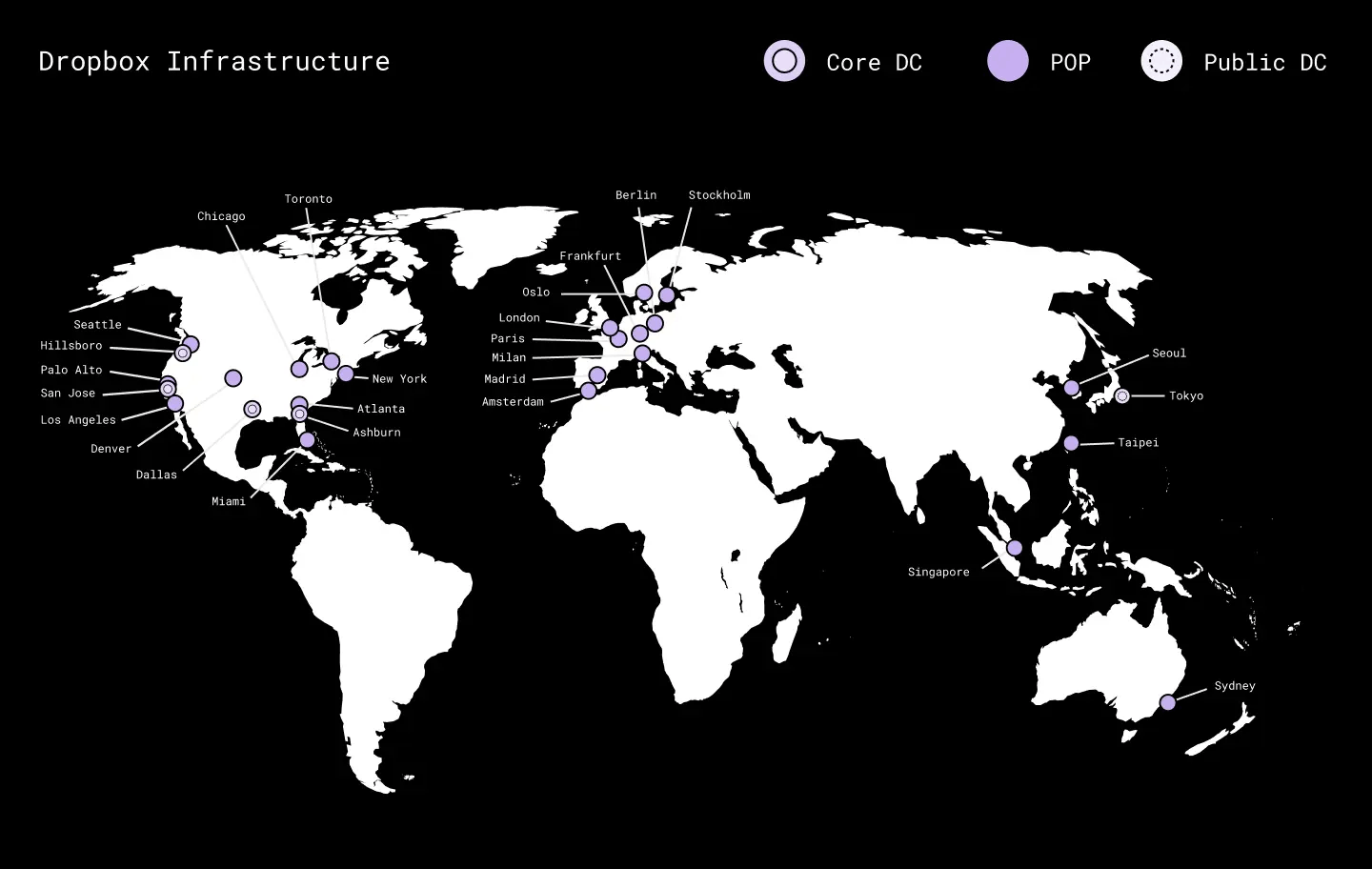

Dropbox プラットフォームは、データ センター、グローバル バックボーン、パブリック クラウド、エッジ ポイントオブプレゼンス(POP)を網羅するハイブリッド クラウド インフラストラクチャ上で稼働しています。増大するリソース ニーズへの対応を効率化するため、Dropbox ハードウェア チームは、最新で最先端のコンポーネントを使用した高性能サーバー ラックの再設計を続けています。最近、この設計は、サーバー ラックの帯域幅要件が 100G イーサネットの能力を超えると予想される臨界密度に達しました。たとえば、今後導入予定の第 7 世代ストレージ サーバーでは、データ レプリケーションの SLA を満たすために、ラックごとに 200G ネットワーク インターフェース カード(NIC)と 1.6 Tb/秒のアップリンク帯域幅が必要になります。

より多くの 100G リンクを備えたより大規模なデバイスを使用して 100G ベースのアーキテクチャを拡張することを検討しましたが、これは電力、ケーブル配線、材料の観点から無駄が多いと判断しました。遅くとも今後 24 か月以内に 400G へのアップグレードが避けられないと予測し、数百のデバイスと数千の光学系で構成される 100G アーキテクチャを応急処置として導入しても、それが 1、2 年以内に電子廃棄物になるだけであるのは持続可能性の目標に反すると考えました。

400G の採用を決定した理由には、当社のサーバー設計チームによるハードウェアの進歩、Dropbox にアップロードされる動画や画像の増加、そして当社の最新の製品機能である Dash、Capture、Replay の採用拡大があります。当社のハードウェア チームとストレージ チームは、ホストあたり最大 200G のネットワーク インターフェース速度と、現行世代の ToR スイッチのスイッチング速度 3.2 Tb/秒を大幅に超えるスループット要件を必要とするサーバーの製造最終段階に入っています。

最終的な設計では、ファブリック コア、ToR スイッチへの接続、データ センター インターコネクト ルーター、光トランスポート シェルフというネットワークの 4 つの区分で効率が向上しました。

2. ファブリック コア:光学部品の排除、高エネルギー効率

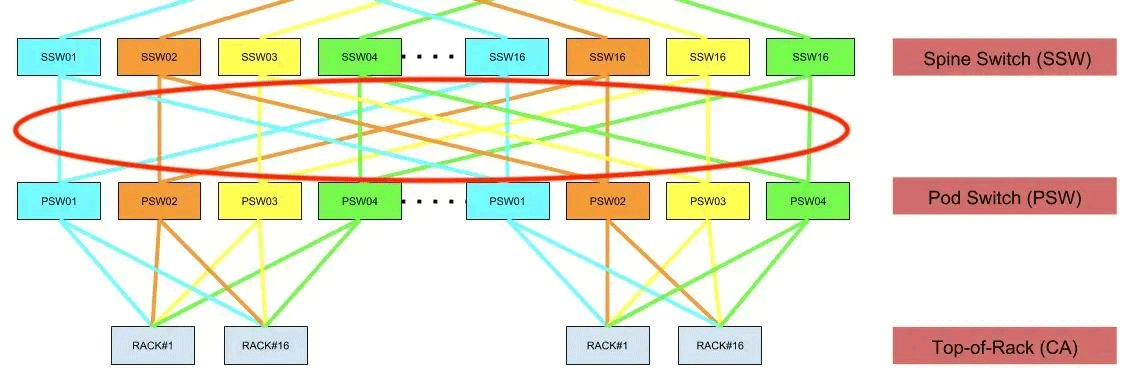

400G データ センターの設計では、従来どおり本番運用実績のあるクワッドプレーン ファブリック トポロジーを中核に据えましたが、新たに 3.2T 32x100G スイッチ デバイスの代わりに 12.8T 32x400G スイッチを使用しました。ファブリック アーキテクチャを維持することで、既存の 100G 設計の望ましい機能(ノンブロッキングのオーバーサブスクリプション率、小さな障害ドメイン、オンデマンドの拡張が可能なモジュラー設計)を保ちながら、速度を 4 倍に速めることができました。

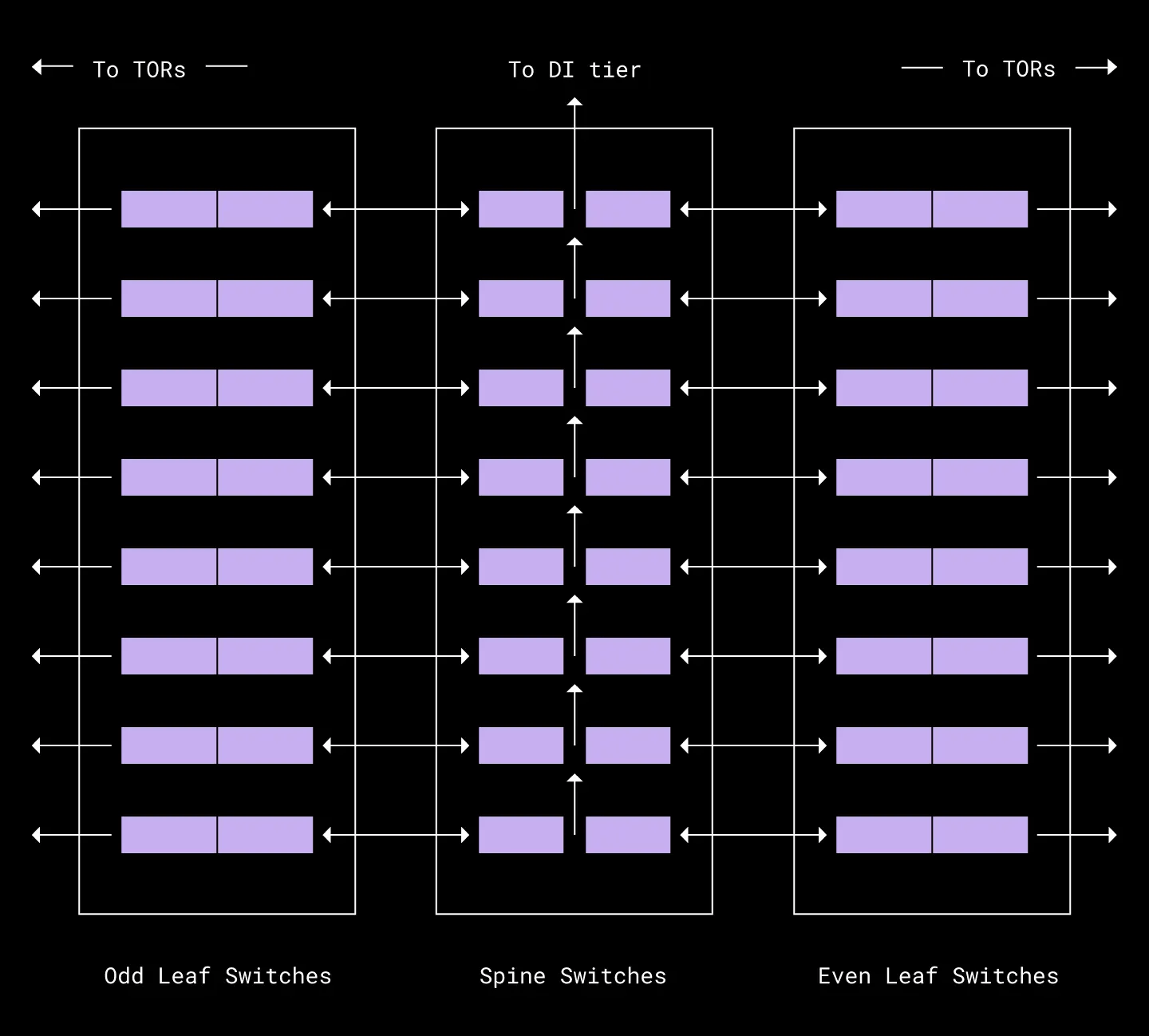

重要なのは、電力要件を拡大することなく、これを実現できたことです。これは、密集したスパイン リーフ間の接続リンクに 400G ダイレクト アタッチ銅線(DAC)ケーブルを活用することで実現しました。400G-DAC は電気的にパッシブなケーブルで、実質的に追加の電力や冷却を必要としないため、これを選択することで、400G スイッチ自体を稼働させる高速チップのエネルギー要件の増加を完全に相殺することができました。

新しい 400G ファブリック コアと従来の 100G データ センターの電力使用指標を比較すると、400G ファブリックの方がギガビットあたりのエネルギー効率が 3 倍高いことが確認できます。

400G-DAC の欠点は、到達距離が 3 メートルと短く、ケーブルが太いことでした。そこで、デバイスの配置、ポートの割り当て、ケーブル管理戦略のさまざまな組み合わせを綿密に計画し、ラボで模擬実験を行うことによって、ついには最適な構成に到達し、これらの制約を解決しました。最終的に見いだしたのは、当社が「奇数-偶数分割」と呼ぶ、下の図のような主配線盤(MDF)の設計です。

3. ToR インターコネクト:下位互換性

考慮する必要のあったもう 1 つの重要なアーキテクチャ コンポーネントは、データ ホールの ToR スイッチを 400G ファブリック コアに接続する光ファイバー プラントでした。これらのリンクは、次の 3 つの要件に基づいて設計されました。

- 既存の 100G と次世代の 400G ToR スイッチの両方への接続をサポートする必要性

- 数メガワット規模のデプロイメントに対応するために、これらの配線を最大 500 メートルまで延長する能力

- 電力使用量と材料コストを最適化しながら、最も信頼性の高いインフラを提供するという要望

この役割でさまざまな 400G トランシーバーをテストした後、前述の 3 つの要件に最も適合する 400G-DR4 光モジュールを選択しました。

- 400G-DR4 は、4x100G-DR リンクにファン アウトすることで、既存の 100G ToR スイッチをサポートできます。内蔵のデジタル シグナル プロセッサ チップは、スイッチ自体の演算負荷を増やすことなく、400G と 100G の信号を変換できます。

- 400G-DR4 光トランシーバーの最大到達距離は 500 メートルで、当社の最大規模のデータ センター施設でも距離要件を満たしています。

- 400G-DR4 光トランシーバーは 1 台あたりの最大消費電力が 8 ワットであり、2.5 ワットの 4x100G-SR4 光モジュール(2.5 × 4 = 10 W)よりもエネルギー効率に優れています。また、400G-DR4 はシングルモード ファイバーで動作するため、前世代の 100G アーキテクチャで使用していたマルチモード ファイバーよりも製造に必要なエネルギーと材料が 30 % 少なくて済みます。

4. データ センター間接続:効率性と拡張性の向上

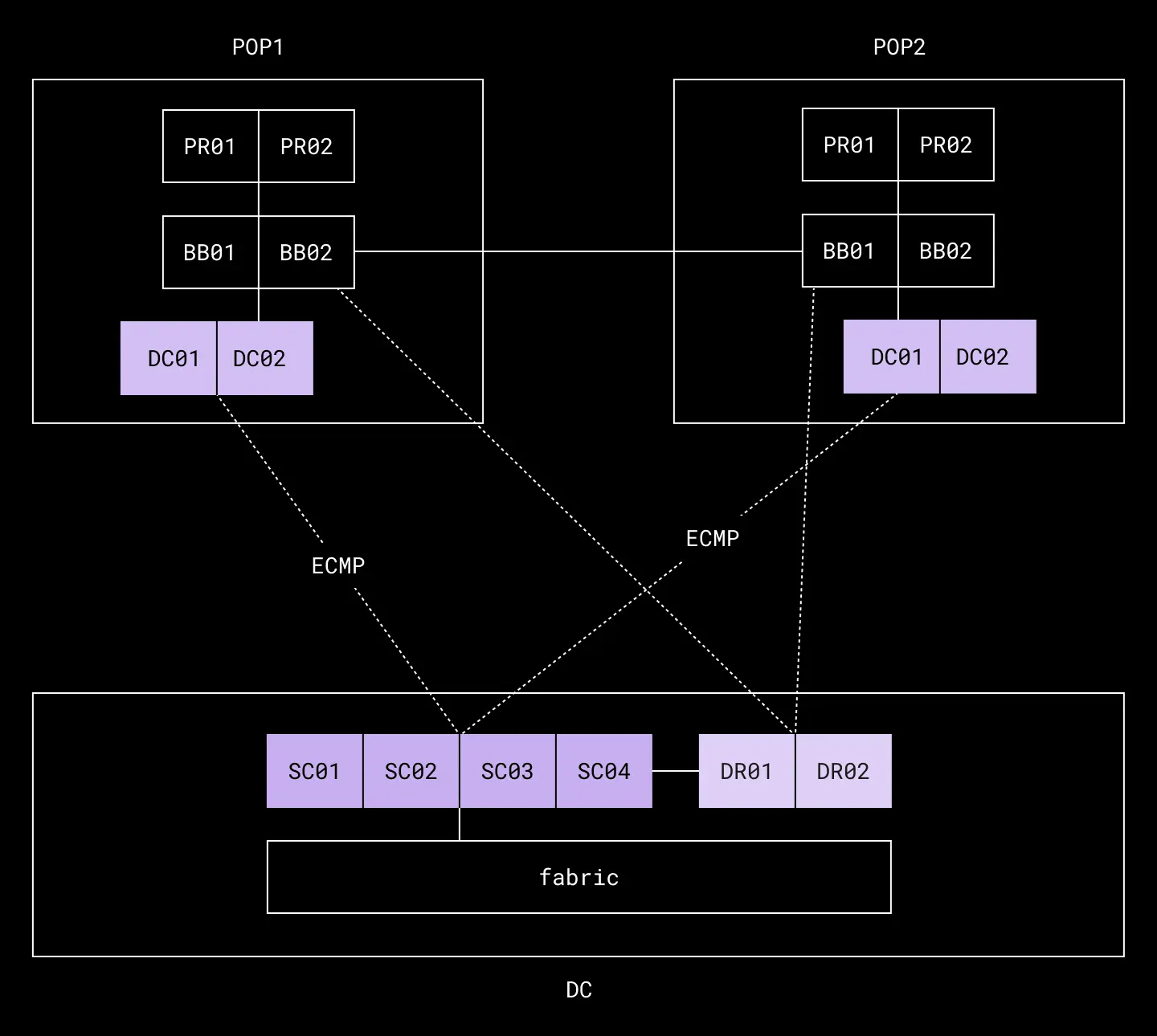

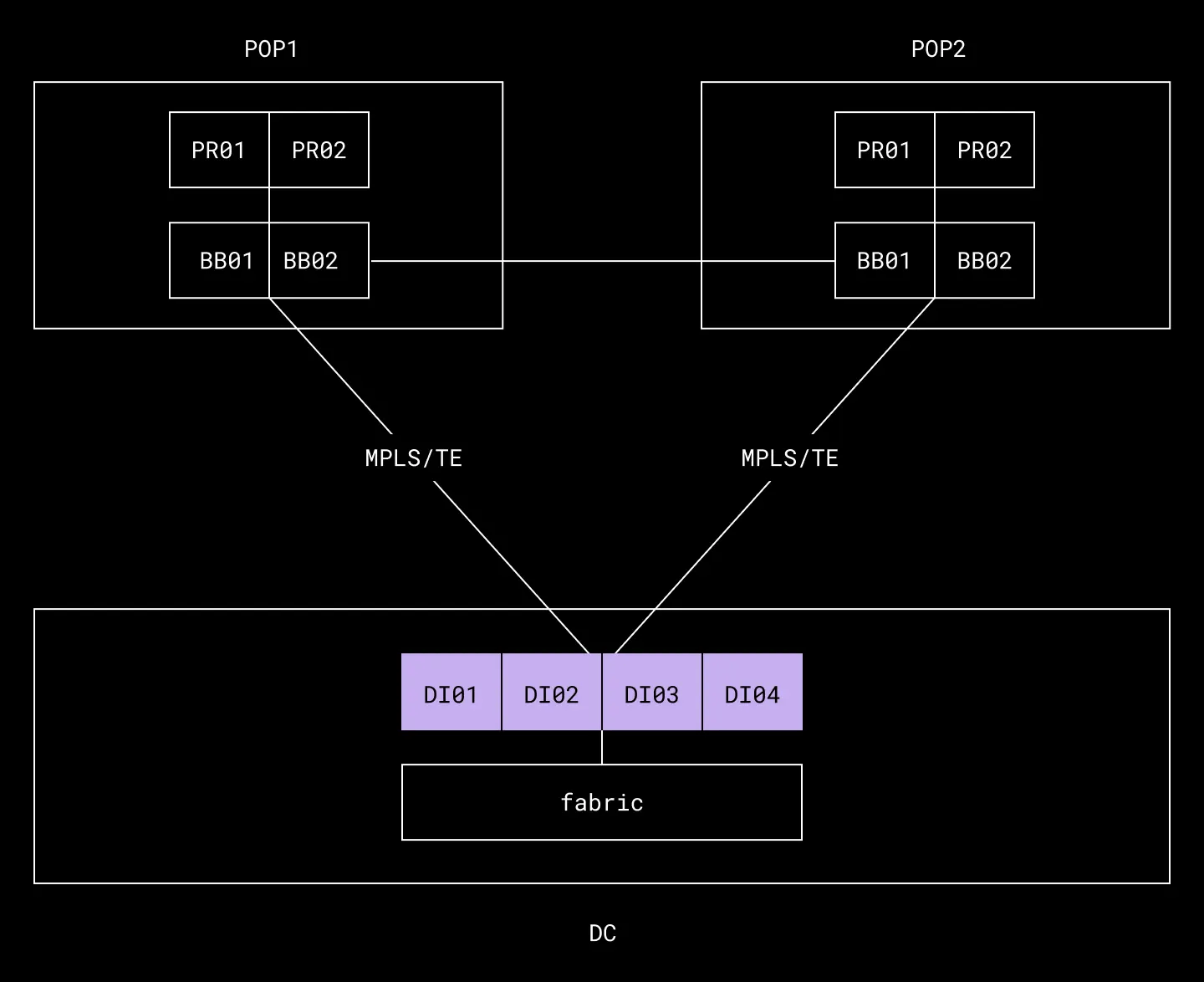

帯域幅密度の向上と、より強力で機能豊富なネットワーキング層の最新仕様を反映するため、データ センター間接続(DI)レイヤーが全面的に刷新されました。現在、DI のトラフィック パターンは以下の要素で構成されています。

- データ センター間のクロスデータセンター トラフィック

- Dropbox の顧客、クラウド ストレージ プロバイダ、企業ネットワークなど、データ センターと POP の間の外部トラフィック

以前のネットワークでは、これらのトラフィック タイプを管理するために、データ センター間のトラフィック用の階層と、データ センターと POP の間の外部トラフィック用の階層を使い分けていました。これには、下の図に示す 3 つの個別ネットワーキング デバイスが関与していました。

400G テクノロジーにより、これら 3 つのデバイスを 1 つのデータ センター間接続に統合することが可能になりました。同時に、初期の階層設計では利用できなかったクラスベースの転送などの機能により、QoS マーキングを使用して、適切な優先度が設定された異なるラベル スイッチ パス上でトラフィックを論理的に分離できるようになりました。

最適化された DI 層にはいくつものメリットがあります。

- 階層で使用されるデバイスの数が 60 % 削減されます。その結果、スペース利用率とエネルギー効率が著しく改善され、デバイス コストが大幅に削減され、ネットワークの環境的および経済的な持続可能性が向上します。

- 新しいアーキテクチャでは、ECMP の代わりに MPLS RSVP TE を利用することで、データ センターのエッジ帯域幅が意識されるように、耐障害性と効率性が向上します。

- 新しいアーキテクチャでは、ルート集約とコミュニティ タグの組み込みや、ファブリックへのデフォルト ルートのみのアドバタイズにより、ルーティングを効率化できます。

- 新しい DI 層は、100G ベースのハードウェアおよびテクノロジーとの下位互換性をシームレスに保っているため、既存の 100G ハードウェアの投資価値を活用しながら、ネットワークの特定部分をアップグレードできます。

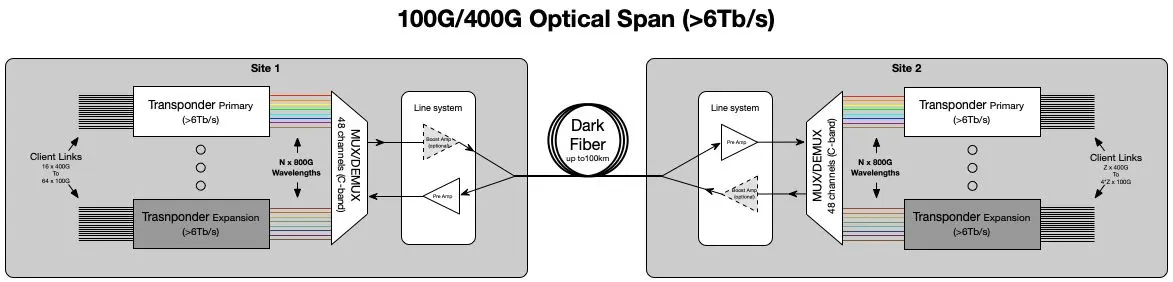

5. 光トランスポート:バックボーン接続

光トランスポート層は、データ センターとバックボーンの間のすべてのデータ プレーン接続を担う高密度波長分割多重(DWDM)システムです。新しいアーキテクチャでは、データ センターとメトロ内の各バックボーン POP との間に 2 本の光ファイバーを利用することで、データ センターに対してネットワーク容量 6.4 Tb/秒の完全に異なる回線を 2 つ提供し、合計 12.8 Tb/秒の利用可能容量を実現します。このシステムは、未使用の光ファイバーを追加する必要なく、最大 76.8 Tb/秒(38.4 Tb/秒)まで拡張できます。

これに対して、この DWDM システムを使用しない場合、1 対のファイバーで伝送できる最大容量は 400 Gb/秒です。

現行世代の光学層では、800 Gb/秒のチューニング波長(前世代では 250 Gb/秒)を新たに採用することで、密度が大幅に向上し、以前のデプロイメントに比べてギガビットあたりのコストを大幅に削減することが可能になりました。さらに、この層は 100G/400G クライアント リンクのデプロイメントに大幅な柔軟性を持たせるように設計されています。このアーキテクチャの多面的な性質により、Dropbox は商品不足による機器納入の予期せぬ遅延にも対応でき、400G データ センターを予定どおりに稼働させることができました。

6. まとめ

2022 年 12 月の稼働以来、初めての 400G データ センターは Dropbox のお客様に驚くべき速度でサービスを提供してきました。2023 年末までには、さらに多くの施設の運用が始まる予定です。しかし、新規技術開発の例に漏れず、400G を採用したことによって私たちは新しい障害を乗り越え、その中で新たな道を切り拓くことを余儀なくされました。

これまで数年にわたって歩んできた道のりから学んだ教訓をいくつか紹介します。

- すべてのコンポーネントに対する入念なテスト:設計に含まれる 400G ルーター、スイッチ、ケーブル、光学系のすべてが、この種の製品として初めて製造されたものであるため、チームはマルチベンダー アーキテクチャにおける各製品のパフォーマンスと相互運用性を評価する必要があることを認識していました。そのため、将来規模のワークロードをエミュレートできるパケット ジェネレーターを備えた専用の 400G テスト ラボを設計し、各コンポーネントの物理的および論理的ストレス テストを実施しました。

- 400G と 100G の境界における下位互換性の確保:テスト中に、本番環境に幅広く導入している 100G ToR スイッチが、既存の 100G ToR スイッチを新しい 400G ファブリックに接続するために選んだ 100G-DR 光トランシーバーに対応していないことがわかりました。幸いこの問題は早期に表面化したため、この光学系のサポートを追加するパッチをベンダーにリクエストする時間の余裕がありました。

- サプライ チェーンの逆風に備えた緊急対応計画の策定:400G を設計、構築する過程におけるグローバル サプライ チェーンの状況は、予測できない不幸な現実でした。設計では、各コンポーネントの供給元を複数定めることで、こうしたリスクを軽減しました。400G DI デバイスを供給するベンダーがチップ不足のために立ち上げの 1 か月前に撤退したとき、チームは急いで緊急対応計画を策定しました。400G QSFP-DD ポートは 100G QSFP28 光モジュールとの下位互換性があるため、400G の恒久的な代替品に取り替えるまでは 100G デバイスを DI の役割で使用するという一時的な相互接続戦略を考え出しました。

7. 次のステップ

初の 400G データ センターの立ち上げに成功したことで、Dropbox のプロダクション ネットワークの他のエリアでも 400G テクノロジーの展開を続けるために必要な自信が得られました。2023 年末までには、これと同じ設計に基づく 400G データ センターが米国中部と米国東部で運用を始める予定です。400G ToR スイッチを搭載した第 7 世代サーバーのテスト ラックは、米国西部ですでに稼働しており、2024 年初頭には大規模展開される予定です。また、2024 年から 2025 年にかけて 400G を Dropbox のバックボーンに拡張する予定です。

最後に、400G-ZR+ と呼ばれる新しい長距離光技術がさらに大幅な効率向上を約束しています。400G-ZR+ では、高さ 3.7 メートルほどの既存の光トランスポート シェルフをチューインガム 1 枚くらいの大きさのプラガブル トランシーバーに置き換えることができます。